Articoli estratti dalla tesi

- Urban Informatics e dinamiche urbane

- Data Clustering Spaziale basati su densità

- Recursive data clustering through finding vague solutions

- An adaptive agent for Google Place crawling

- Link al lavoro di tesi completo

- GitHub code: Adaptive Geolocated-data crawler

Trascrizione della discussione di laurea

Analisi di dati geospaziali per applicazioni di Urban Informatics: il caso dei Google Place nella città di Milano

2018

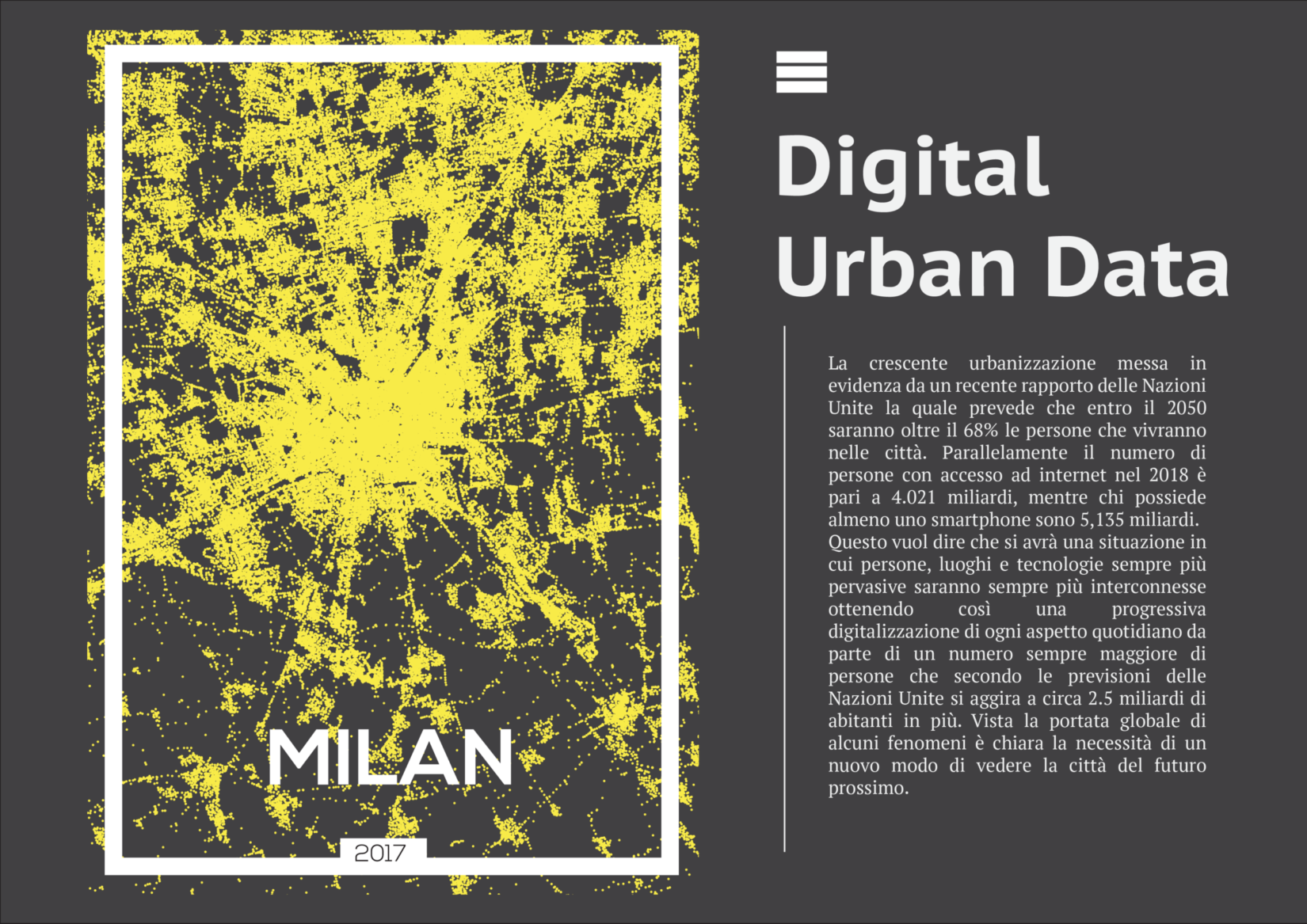

Una sempre maggiore urbanizzazione del territorio sta progressivamente portando a stretto contatto persone, luoghi e tecnologie -queste ultime- sempre più pervasive nelle aree urbane, ottenendo così una progressiva digitalizzazione di ogni aspetto quotidiano.

É questo il contesto socio-tecnologico in cui si posiziona la Urban Informatics, una disciplina di ricerca nata dall’unione delle Scienze Informatiche e Scienze Urbane. Essa introduce novità in termini di tecnologie e metodologie per il trattamento di nuovi Dati digitali che possono fornire nuove applicazioni a nuovi stakeholder della città.

Da queste motivazioni nasce l’idea di un analisi bottom-up della città di Milano, che a partire da contenuti generati degli utenti (quindi dal basso del processo) possa fornire un caratterizzazione delle aree urbane attraverso un processo composto da:

- un’acquisizione dei dati (GitHub code, Peper);

- suddivisione della città in aree;

- un’analisi caratterizzazione delle aree estratte.

Quali dati?

Una delle prime domande a cui bisogna rispondere per realizzare un progetto di questo tipo è:

Quali sono i dati che permettono di comprendere le dinamiche della città dal basso?

La risposta risiede, in prima battuta, da tutti quei dati generati volontariamente o involontariamente dagli internauti attraverso i Social Media, i problema in questo senso è scegliere quelli che meglio rispondo alle esigenze del caso.

Per il presente lavoro di tesi, come contenuti generati dagli utenti, ho scelto i Google Place perché a mio pare quelli che con il minor lavoro è possibile ricondurre a contesti urbani, oltre che per il loro utilizzo concreto e duraturo da parte degli utenti, cosa che manca in progetti come Foursquare.com.

In oltre essi non sono totalmente generati dagli utenti, ma in qualche modo sono monitorati e migliorati dal workflow di Google, ma vengono considerati comunque come generati dagli utenti in quanto le informazioni di base sono comunque il frutto di modifiche ed inserimenti degli utenti.

Come acquisirli?

Il processo di acquisizione dei Place realizzato per il presente lavoro di tesi avviene attraverso processo adattivo in 3 step (GitHub code, Peper):

- una prima pianificazione delle aree da analizzare;

- seguita successivamente dalla collezione dei Place a partire da dall’area più centrale;

- ed infine viene una ri-pianificazione a grana più fine di aree troppo dense di Place;

In totale, il processo appena descritto, ha raccolto circa 290000 Place sulla città di Milano, in un area di raggio pari a 52km avvenuto in circa 20giorni di acquisizione.

Come suddividere la Città?

Sarebbe potuto bastare ricondurre i Place alle aree di tipo amministrativo della città di Milano, ma mi sono spinto oltre. Infatti si è scelto di lasciare appunto ai Place il compito di comunicarmi una “possibile suddivisione della città”, appunto dal basso.

Per fare questo si è scelto di utilizzare l’algoritmo di clustering DBSCAN, perché molto utilizzando su dati spaziali e necessita di poca conoscenza sul dominio, ad esempio non serve conoscere il numero di cluster da generare, ma è sufficiente un valore di densità espresso nei termini richiesto dall’algoritmo.

Ma il DBSCAN non privo di criticità, che si è tentato di risolvere attraverso un algoritmo Ricorsivo, che io chiamo, nella tesi “Clustering Gerarchico-Iterativo” e che recentemente ho ri-denominato in “Recursive data clustering through finding vague solutions“.

Il metodo sviluppato è del tutto generico, ma è stato applicato sul DBSCAN, in particolare a partire dal un dataset iniziale viene applicato iterativamente ( o ricorsivamente, in base ai punti di vista) un processo che genera un insieme di clustering diversi, dai quali se ne sceglie uno solo attraverso una serie di regole.

Una volta selezionato il clustering desiderato, vengono selezionati quei specifici cluster che, secondo un secondo gruppo di regole, possono (o devono) essere ri-analizzati. Realizzando così la ricorsione.

La fase di scelta del clustering

Una delle fasi più importanti del processo di clustering è la selezione della suddivisione dei punti che più rispecchia le nostre aspettative. In particolare per ogni Clustering (o suddivisione) vengono calcolati una serie di “indicatori” attraverso i quali viene scelto il clustering più simile a quello che stiamo cercando.

Dunque l’algoritmo, a partire da un dataset iniziale, genera una serie di suddivisioni dello spazio e ricorsione ne sceglie una sola, sulla quale applica un ulteriore processo decisionale scegliendo quali cluster suddividere e quali no.

Sino ad arrivare ad una gerarchia di cluster, ognuno a densità diversa, estratti a partire da uno stesso dataset, dove in questo caso, i Cluster finali sono rappresentati dalle foglie dell’albero.

Come caratterizzare i cluster?

Una volta ottenuti i cluster “dal basso” della città di Milano è stato necessario caratterizzarli, darli una connotazione, oltre che spaziale, semantica. Ma non essendo riconducibili ad aree amministrative, l’unica connotazione semantica possibile era quella del tipo di servizi in essi contenuti.

A questo proposito sono state realizzate alcune analisi esplorative che hanno avuto lo scopo di provare a caratterizzare i cluster estratti.

In particolare, utilizzando le “categorie” associate ad ogni place, sono state realizzate delle rappresentazioni vettoriali, prima dei place, e successivamente dei cluster; che permettevano di dare una rappresentazione machine-ready dei diversi cluster.

Una prima analisi realizzata sulla base di queste rappresentazioni vettoriali è stata quella distribuzione in termini assoluti di una determinata categoria di servizio rispetto ai cluster. Banalmente se per il 50% dei place di un cluster ci fossero Bar piuttosto che uffici.

Per fare questo sono state realizzate due principali analisi:<

- Una che teneva conto della numerosi delle varie categorie di servizi;

- Una che teneva conto anche della loro numerosità: sia normalizzati (normalizzato 0-100) che in termini reali.

Breve conclusione

Il progetto svolto, durato circa un anno Luglio 2017 – Ottobre 2018, ha fatto emergere diverse criticità, e nel contempo buone possibilità di approfondimento delle tecniche sviluppate:

- Senza dubbio l’algoritmo di crawling dei dati è del tutto autonomo e riutilizzabile non solo per altre città, ma anche su altri Social Media o addirittura su scopi diversi dal presente;

- L’algoritmo Ricorsvio di Clustering risolve alcuni problemi, ma introduce un numero abbastanza alto di parametri per configurarli; ma una volta definiti il suo funzionamento è efficace ed efficiente

- In fine le analisi per la caratterizzazione dei cluster hanno fatto emergere da una parte il potenziale dei dati generati dagli utenti, ma dall’altro anche la loro debolezza in termini di ricchezza di informazioni;

Quest’ultimo punto risolvibile o mitigabile attraverso un’analisi incrociata dei dati al fine di permettere una migliore comprensione delle informazioni emerse. Questo, ci porta direttamente ad una serie di sviluppi futuri come la possibilità applicare lo stesso studio ad altre città e quindi confrontarne i risultati, sfruttare i significati semantici delle categorie dei type ed replicare lo stesso approccio su Social Media diversi.

Alcuni link al lavoro di tesi:

- https://www.researchgate.net/publication/332144549_Analisi_di_dati_geospaziali_per_applicazioni_di_Urban_Informatics_il_caso_dei_Google_Place_nella_citta_di_Milano

- https://www.slideshare.net/kiuz_it/analisi-di-dati-geospaziali-per-applicazioni-di-urban-informatics-il-caso-dei-google-place-nella-citt-di-milano

- https://www.researchgate.net/publication/332587053_Recursive_data_clustering_through_finding_vague_solutions/stats